简要

参考资料:《深度学习》(花书)。

此模板仅作知识的查漏补缺,因此不作全面具体介绍。

矩阵相关

矩阵转置

(A⊤)i,j=Aj,i

单位矩阵和逆矩阵

单位矩阵:In(In∈Rn∗n)

∀x∈Rn,Inx=x

矩阵 A 的矩阵逆记作 A−1 ,其定义的矩阵满足如下条件:

A−1A=In

可通过下式求解(当逆矩阵存在时):

Ax=b

A−1Ax=A−1b

Inx=A−1b

x=A−1b

线性相关和生成子空间

若 x 和 y 都是某方程组的解,则

z=αx+(1−α)y

也是该方程组的解( α 取任意实数)

为分析方程 Ax=b 有多少个解,可以将 A 的列向量看作是从原点(元素为0的向量)出发的不同方向,确定有多少种方法可以到达向量 b 。此时,向量 x 中的每个元素表示我们应该沿着这些方向走多远,即 xi 表示需要沿着第i个向量的方向走多远

Ax=i∑xiA:,i

这种操作被称为 线性组合。

形式上,一组向量的线性组合,是指每个向量乘以对应标量系数之后的和。

i∑civ(i)

生成子空间: 原始向量线性组合后所能抵达的点的集合

假设有一个 R2∗2 的矩阵,两个列向量相同,列向量冗余,其列空间为一条线,不能覆盖整个 R2 空间。

这种冗余被称为 线性相关。

范数

范数: 衡量向量大小的函数,定义如下,其中 p∈R,p≥1 。

∥x∥p=(i∑∣x∣p)p1

特殊类型的矩阵和向量

对角矩阵: 只在主对角线上含有非零元素的矩阵。 i=j,Di,j=0

对称矩阵: 转置和自己相等的矩阵。 A=A⊤

单位向量: 具有 单位范数 的向量。 ∥x∥2=1

若 x⊤y=0,那么向量 x 和 y 互相 正交。如果两个向量都有非零范数,那么这两个向量之间的夹角是90度。在 Rn 中,至多有 n 个范数非零向量互相正交。如果这些向量不仅互相正交,并且范数都为1,那么称它们为标准正交。

正交矩阵: 行向量和列向量是分别标准正交的矩阵。 A⊤A=AA⊤=I, A−1=A⊤

特征分解

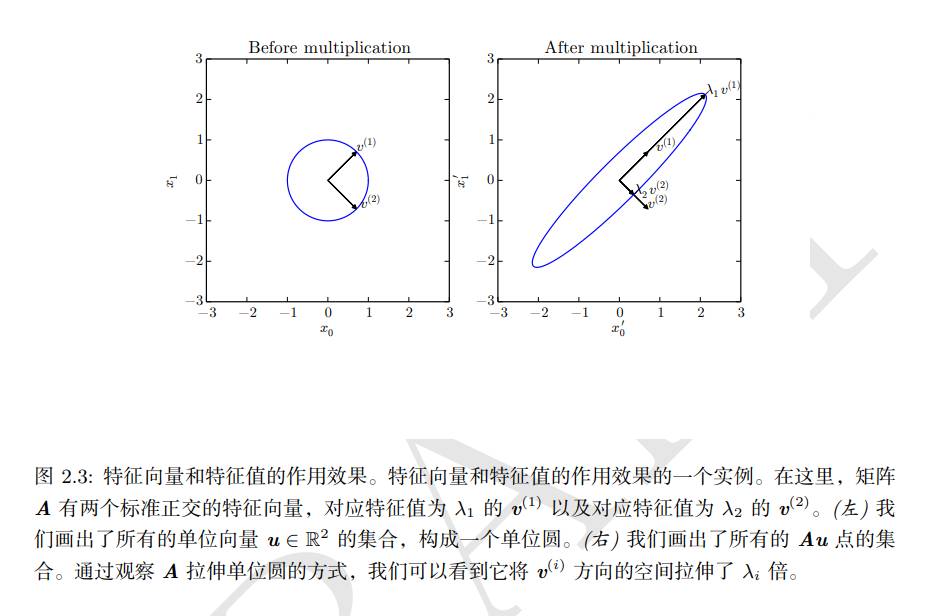

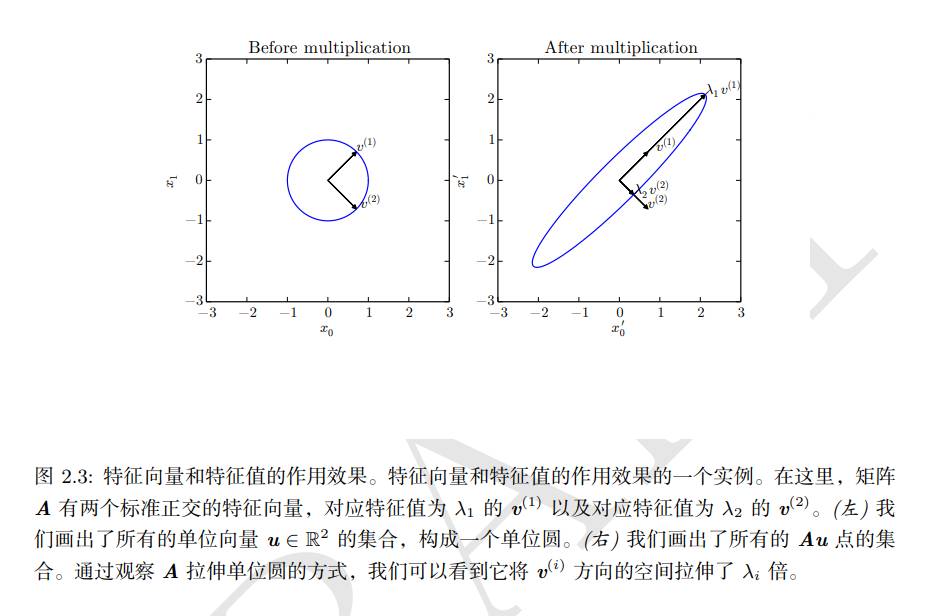

特征分解: 将矩阵分解成一组特征向量和特征值。

方阵 A 的特征向量是指与 A 相乘后相当于对该向量进行缩放的非零向量 v:

Av=λv

标量 λ 被称为这个特征向量对应的 特征值。(类似地,我们也可以定义 左特征向量 v⊤A=λv⊤,但是通常更关注 右特征向量)。

如果 v 是 A 的特征向量,那么任何缩放后的向量 sv(s∈R,s=0) 也是 A 的特征向量。此外,sv 和 v 有相同的特征值。基于此原因,通常只考虑单位特征向量。

假设矩阵 A 有 n 个线性无关的特征向量 {v(1),…,v(n)},对应着特征值 {λ1,…,λn} 。将特征向量连接成一个矩阵,使得每一列是一个特征向量:V=[v(1),…,v(n)],类似地,可以将特征值连成一个向量 λ=[λ1,…,λn]⊤。因此 A 的 特征分解 可以记作

A=Vdiag(λ)V−1

- 不是每一个矩阵都可以分解成特征值和特征向量。

- 每个实对称矩阵都可以分解成实特征向量和实特征值:

A=QΛQ⊤

其中 Q 是 A 的特征向量组成的正交矩阵, Λ 是对角矩阵。特征值 Λi,i 对应的特征向量是矩阵 Q 的第 i 列,记作 Q:,i。因为 Q 是正交矩阵,可以将 A 看作是沿方向 v(i) 延展 λi 倍的空间。